近期,由艾伦人工智能研究所、伊利诺伊大学厄巴纳-香槟分校和华盛顿大学的研究人员联合开发的“Unified-IO2”标志着人工智能能力的一次巨大飞跃。

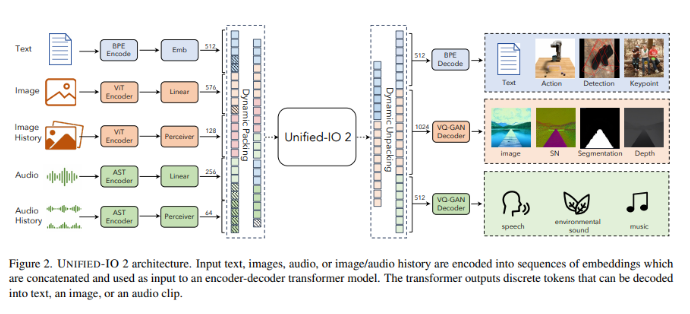

与之前只能处理双模态的前辈不同,Unified-IO2是一款自回归的多模态模型,能够解释和生成文本、图像、音频和视频等多种数据类型。作为第一款在多模态数据上从零开始训练的模型,其架构基于单一的编码器-解码器变压器模型,独特设计将各种输入转换为统一的语义空间。这种创新性的方法使得该模型能够同时处理不同类型的数据,克服了以往模型在处理多模态数据时的限制。

Unified-IO2的方法复杂而创新。它采用共享表示空间来对各种输入和输出进行编码,通过使用字节对编码文本和用于编码稀疏结构(如边界框和关键点)的特殊标记来实现。图像通过预训练的视觉变压器进行编码,线性层将这些特征转换为适用于变压器输入的嵌入。音频数据经过类似的处理,转换成频谱图并使用音频频谱变压器进行编码。模型还包括动态打包和多模态去噪器目标的混合,以增强其处理多模态信号的效率和效果。

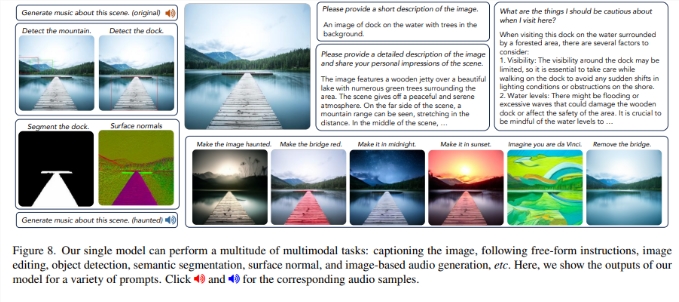

Unified-IO2不仅在设计上令人印象深刻,其性能也同样令人惊叹。在超过35个数据集上进行评估,它在GRIT评估中创下了新的基准,在关键点估计和表面法线估计等任务上表现出色。在视觉和语言任务中,它与许多最近提出的视觉语言模型相匹敌甚至表现更好。尤其值得注意的是,在图像生成方面,它在忠实度方面超越了最接近的竞争对手。该模型还能有效地从图像或文本中生成音频,展示了其在广泛能力范围内的多才多艺。

Unified-IO2的开发和应用所得的结论是深远的。它代表了人工智能处理和整合多模态数据方面的显著进步,为人工智能应用开辟了新的可能性。它在理解和生成多模态输出方面的成功突显了人工智能更有效地解释复杂现实场景的潜力。这一发展标志着人工智能领域的一个重要时刻,为未来更为细致和全面的模型铺平了道路。

Unified-IO2象征着人工智能内在潜力的信标,标志着向更为整合、多才多艺和强大系统的转变。它成功地驾驭了多模态数据整合的复杂性,为未来人工智能模型树立了一个先例,预示着人工智能将更准确地反映和与人类经验的多面性互动。

论文网址:https://arxiv.org/abs/2312.17172

https://github.com/allenai/unified-io-2

首页

首页

AI对话

AI对话

资讯

资讯  我的

我的