美东时间6月27日周四,OpenAI公布,其研究人员训练了一个基于GPT-4的模型,它被称为CriticGPT,用于捕捉ChatGPT代码输出中的错误。简单来说就是,CriticGPT让人能用GPT-4查找GPT-4的错误。它可以写出使用者对ChatGPT响应结果的批评评论,从而帮助人类训练者在RLHF期间发现错误。

OpenAI发现,如果通过CriticGPT获得帮助审查ChatGPT编写的代码,人类训练师的审查效果比没有获得帮助的人强60%。OpenAI称,正着手将类似CriticGPT的模型集成到旗下RLHF标记管道中,为自己的训练师提供明确的AI帮助。

OpenAI称,因为没有更好的工具,所以人们目前难以评估高级的AI系统的表现。而CriticGPT意味着,OpenAI向能够评估高级AI系统输出的目标迈进了一步。

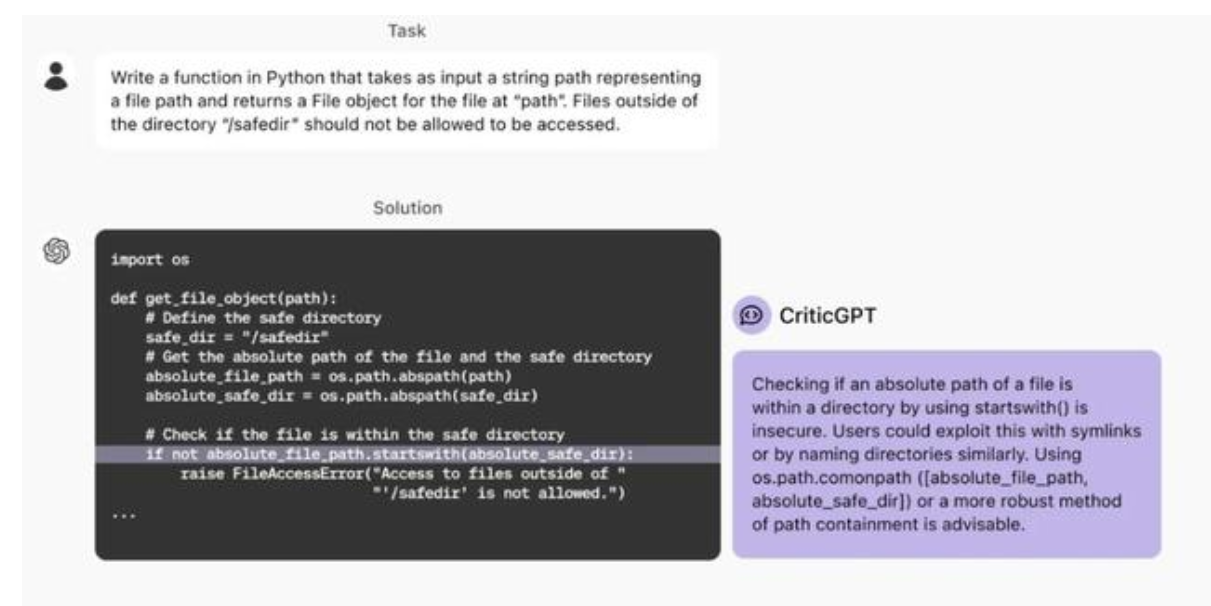

OpenAI举了一个例子,如下图所示,对ChatGPT提出一个用Python编写指定函数的任务,对于ChatGPT根据要求提供的代码,CriticGPT点评了其中一条指令,提议换成效果更好的。

OpenAI称,CriticGPT的建议并不是全都正确无误,但OpenAI的人员发现,相比没有这种AI的帮助,有了它,训练师可以发现更多模型编写答案的问题。

此外,当人们使用CriticGPT时,这种AI模型会增强他们的技能,从而得出的批评结论比单单人类训练师做的更全面,并且比AI模型单独工作时产生的幻觉错误更少。

OpenAI 在开发 CriticGPT 过程中识别出几个关键的挑战:

训练方法的改进需求:目前模型主要基于简短的答案进行训练,这限制了它们处理长且复杂问题的能力。需要探索新的训练策略来提升模型对复杂任务的理解。

幻觉现象的纠正:AI 模型有时会生成不准确或虚构的信息,这被称为幻觉。同时,训练师在识别这些错误时也可能出错,这要求模型和训练师的准确性都需要提高。

错误识别的全面性:现实中的错误可能分布在答案的多个部分,而现有模型通常只能识别出一个错误。未来的工作需要使模型能够识别并纠正分散在不同地方的错误。

评估复杂性的局限:即使在模型的辅助下,专家在面对极其复杂的任务或响应时也可能难以做出准确的评估,这显示了 AI 在处理极端复杂情况时的限制。

此外,OpenAI 强调了为了更有效地管理和协调日益复杂的 AI 系统,需要更先进的工具。他们通过在 GPT-4 上应用 RLHF 方法,发现了一种可能帮助生成更优质 RLHF 数据的方法。OpenAI 计划扩展这项研究,并将其实际应用,以提高 AI 系统的整体性能和稳定性。

图片来源:视觉中国(11.500, -0.15, -1.29%)-VCG31N2008743681

另外值得注意的是,当地时间6月28日,《时代》杂志与OpenAI宣布,两家公司达成了一项多年内容授权协议和战略合作伙伴关系。该协议允许OpenAI将这家出版商的内容引入ChatGPT,并帮助训练其最先进的人工智能(AI)模型。

据新闻稿介绍,OpenAI可以通过这笔交易访问《时代》过去100多年的档案和文章,以训练其AI模型,并在其面向消费者的产品(如ChatGPT)中用于回复用户的询问。

OpenAI使用《时代》杂志的内容时会注明引用并链接原始来源。作为协议的一部分,《时代》杂志将可以使用OpenAI的技术,以便为其受众“开发新产品”。

《时代》杂志首席运营官马克·霍华德表示,在上百年的历史中,《时代》一直在拥抱创新,以确保其值得信赖的新闻报道与技术一起发展。

霍华德强调,而与OpenAI的合作有助于推进《时代》的使命,即在全球范围内扩大对可信信息的获取,同时继续采用创新的新方式将《时代》的新闻带给全球的受众。

OpenAI的首席运营官Brad Lightcap声称,两家公司的合作旨在利用AI技术帮助人们更便捷地获取新闻,并确保提供正确的信源,从而支持高质量的新闻报道。

与此同时,OpenAI还在与数十家出版商洽谈内容授权协议。上个月,OpenAI和新闻集团也达成了类似的合作关系。它将允许OpenAI访问新闻集团旗下媒体的当前和存档文章,包括《华尔街日报》《MarketWatch》《巴伦周刊》《纽约邮报》等。

美国八家新闻机构4月底在纽约联邦法院对OpenAI、微软提起诉讼,指控微软的Copilot和OpenAI的ChatGPT非法复制了数百万篇文章来训练AI模型。这些新闻机构要求OpenAI和微软赔偿它们的损失,并停止进一步侵犯版权行为。

虽然冲突和分歧仍然存在,但目前的趋势是,越来越多的新闻出版商选择与OpenAI等AI公司建立合作关系,而不是提起诉讼。

首页

首页

AI对话

AI对话

资讯

资讯  我的

我的