Meta AI 研究人员推出了 MobileLLM,这是一种为智能手机和其他资源受限的设备设计高效语言模型的新方法。这项研究于2024年6月27日发布,挑战了有关有效 AI 模型必要规模的假设。

该研究团队由 Meta Reality Labs、PyTorch 和 Meta AI Research (FAIR) 的成员组成,专注于优化参数少于10亿的模型。这只是 GPT-4等模型的一小部分,据估计,GPT-4等模型的参数超过一万亿。

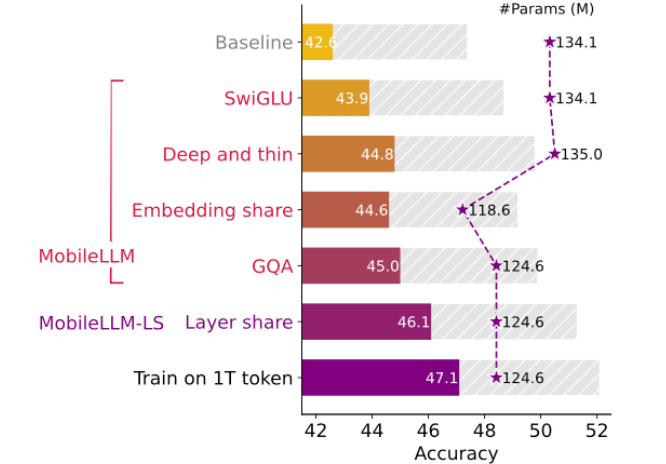

MobileLLM 的主要创新包括:

- 优先考虑模型深度而不是宽度

- 实现嵌入共享和分组查询注意

- 利用一种新颖的直接块权重共享技术

这些设计选择使得 MobileLLM 在常见基准测试任务上的表现比之前类似规模的模型高出2.7% 到4.3%。虽然这些个位数的改进似乎很小,但它们代表了竞争激烈的语言模型开发领域取得的重大进步。

值得注意的是,在某些 API 调用任务上,MobileLLM 的3.5亿参数版本表现出与更大的70亿参数 LLaMA-2模型相当的准确率。这表明,对于某些特定应用,更紧凑的模型可能会提供类似的功能,同时使用更少的计算资源。

MobileLLM 的开发与人们对更高效的 AI 模型日益增长的兴趣相吻合。随着超大型语言模型的进展出现放缓迹象,研究人员越来越多地探索更紧凑、更专业的设计的潜力。尽管名称中带有“LLM”,但对效率和设备部署的关注使 MobileLLM 与一些研究人员所说的小型语言模型 (SLM)属于同一类别。

虽然 MobileLLM 尚未向公众开放,但 Meta 已将预训练代码开源,允许其他研究人员在其工作的基础上继续研究。随着这项技术的发展,它可能会为个人设备带来更先进的 AI 功能,尽管时间表和具体功能仍不确定。

首页

首页

AI对话

AI对话

资讯

资讯  我的

我的