在2024年国际音乐信息检索会议(ISMIR)上,研究人员展示了他们最新研发的MusiConGen模型。这一模型是基于Transformer的文本生成音乐模型,通过引入时间条件机制,显著提升了对音乐节奏和和弦的控制能力。

产品入口:https://ai.cy211.cn/

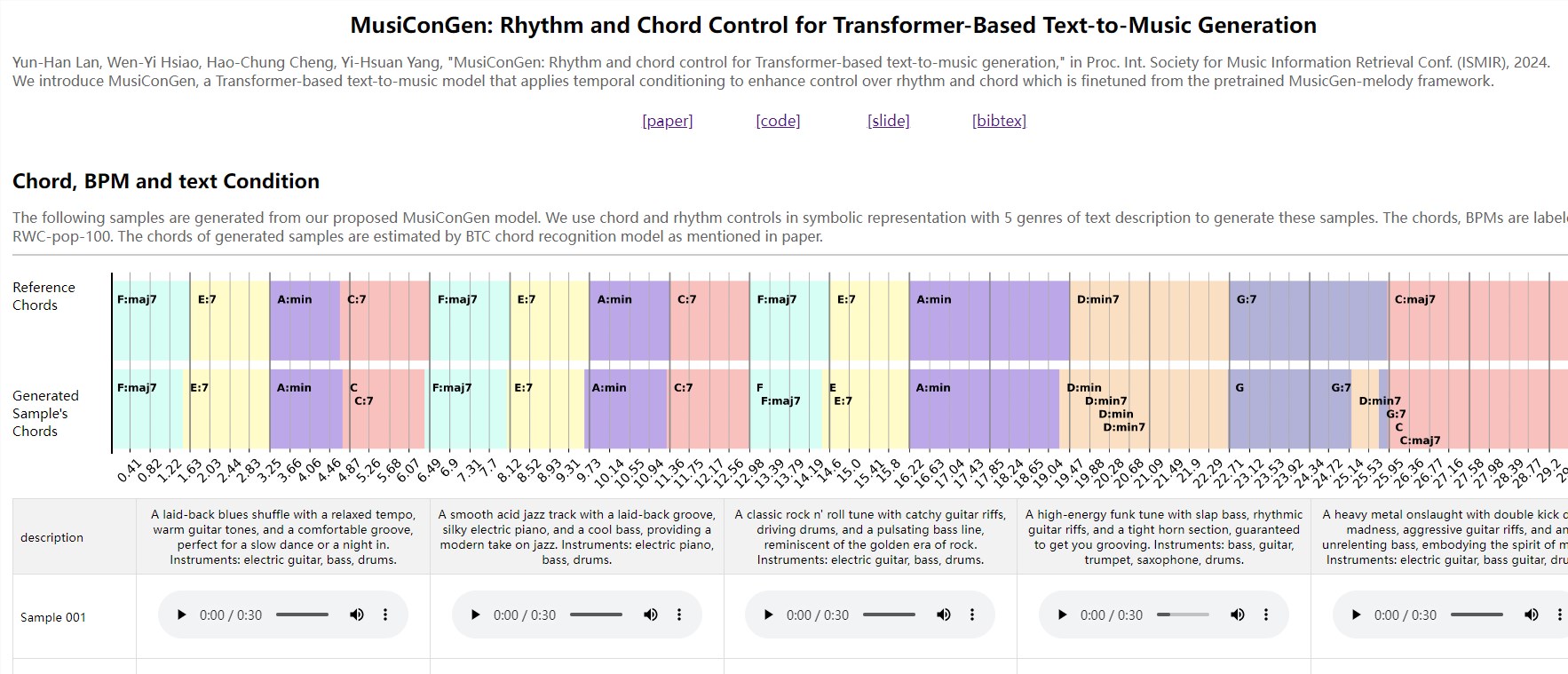

MusiConGen模型是在预训练的MusicGen-melody框架基础上进行微调的,主要用于生成各种风格的音乐片段。研究团队通过设置和弦和节奏的控制参数,展示了模型生成的音乐样本,涵盖了五种不同风格:休闲布鲁斯、平滑酸爵士、经典摇滚、高能放克以及重金属。

每种风格的音乐都有明确的和弦和节奏要求,这些数据来源于RWC-pop-100数据库,生成的和弦通过BTC和弦识别模型进行估计。

为了验证MusiConGen的效果,研究人员将其与基线模型和经过微调的基线模型进行了对比。通过相同的和弦和节奏控制设置,MusiConGen在生成的音乐样本中展示了更高的准确性和风格一致性,体现了其在音乐生成方面的技术优势。

首页

首页

AI对话

AI对话

资讯

资讯  我的

我的