最近,新加坡国立大学的Wenyi Yu及其团队提出了一项名为video-SALMONN的新技术,它不仅能够理解视频中的视觉帧序列、音频事件和音乐,更重要的是,它能够理解视频中的语音内容。这项技术的提出标志着我们在让机器理解视频内容方面迈出了重要一步。

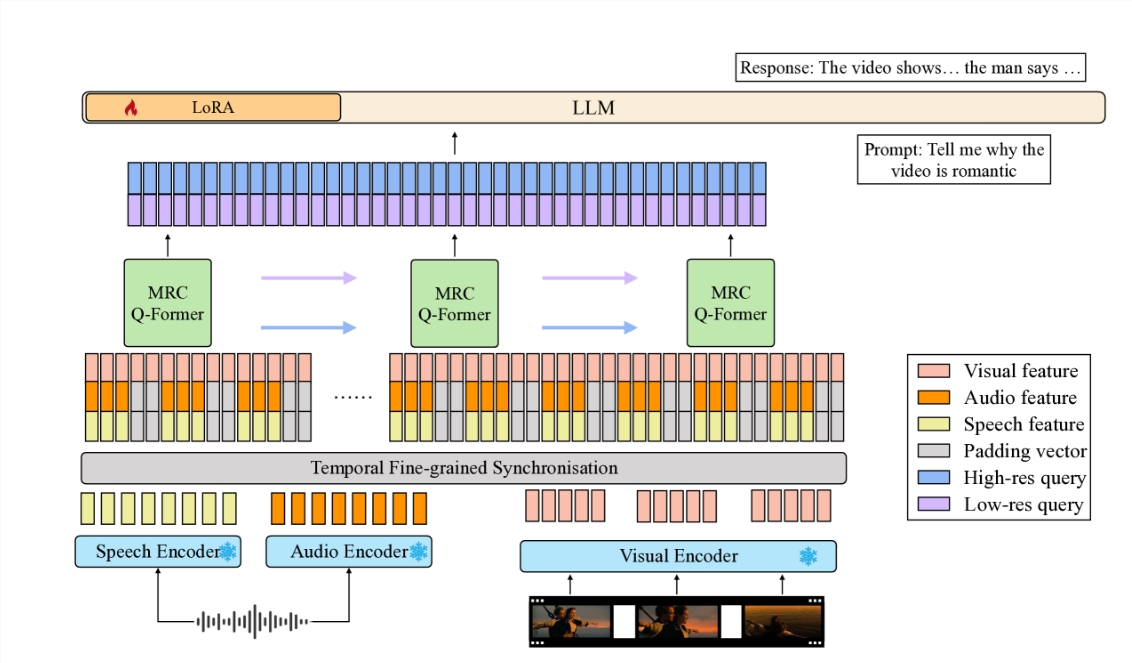

视频-SALMONN是一种端到端的音频-视觉大型语言模型(av-LLM),它通过一种新颖的多分辨率因果Q-Former(MRC Q-Former)结构,将预训练的音视频编码器与大型语言模型的主体连接起来。这种结构不仅能够捕捉到语音理解所需的细粒度时间信息,同时也保证了对其他视频元素的高效处理。

为了提高模型对不同视频元素的平衡处理,研究团队提出了专门的训练方法,包括多样性损失和未配对音视频混合训练策略,以避免视频帧或模态的主导。

在新引入的语音-音频-视觉评估基准(SAVE)上,视频-SALMONN在视频问答(video-QA)任务上取得了超过25%的绝对准确率提升,在涉及人类语音的音视频问答任务上取得了超过30%的绝对准确率提升。此外,视频-SALMONN在其他av-LLMs前所未有的任务上展示了卓越的视频理解与推理能力。

视频-SALMONN的核心是多分辨率因果(MRC)Q-Former结构,它在三个不同的时间尺度上对同步的音视频输入特征与文本表示空间进行对齐,满足不同任务对不同视频元素的依赖需求。此外,为了加强连续视频帧之间的时间因果关系,MRC Q-Former中包含了具有特殊因果掩码的因果自注意力结构。

视频-SALMONN的提出,不仅为学术界带来了新的研究工具,也为实际应用提供了广阔的可能性。它使得技术与人类的交互变得更加自然和直观,降低了用户尤其是儿童和老年人学习使用技术的难度。同时,它还有潜力提高包括运动障碍人士在内的技术的可访问性。

视频-SALMONN的提出,是朝着实现通用人工智能(AGI)迈出的重要一步。通过整合语音输入以及现有的非语音音频和视觉输入,这样的模型将获得对人类交互和环境的全面理解,从而能够应用到更广泛的领域。

这项技术的发展,无疑将为视频内容的分析、教育应用、以及提升人们的生活质量带来深远的影响。随着技术的不断进步,我们有理由相信,未来的AI将更加智能,更加贴近人类的需求。

首页

首页

AI对话

AI对话

资讯

资讯  我的

我的