Meta Reality Labs最近发布了一款名为“Sapiens”的人工智能模型,它在人类视觉任务处理上取得了重大突破。Sapiens模型专门设计用于分析和理解图片或视频中的人及其动作,经过在超过3亿张人类图像上的严格训练,无论是在复杂环境还是数据稀缺的情况下,都能展现出卓越的性能。

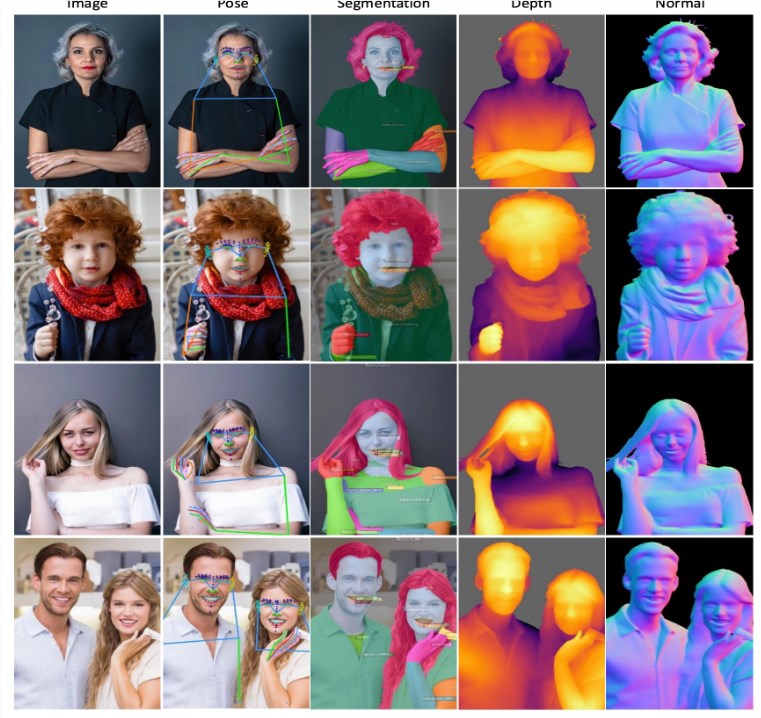

Sapiens模型在超过3亿张人类图像的基础上进行了训练,展现出在复杂环境下处理人类视觉任务的卓越能力。其核心功能包括2D姿态估计、身体部位分割、深度估计和表面法线预测等。这些功能使Sapiens能够精确识别人体姿势,细致区分身体各个部位,并能预测图像中的深度信息和物体表面方向。

从技术角度来看,Sapiens采用了几项先进方法。首先,它基于一个包含3亿张图像的大规模数据集进行预训练,这为模型提供了强大的泛化能力。其次,Sapiens采用了视觉变换器架构,能够处理高分辨率输入并进行细粒度推理。此外,通过遮掩自编码器预训练和多任务学习,Sapiens能够学习鲁棒的特征表示,并同时处理多项复杂任务。

Sapiens的应用前景十分广阔。在视频监控和虚拟现实领域,它可以实时分析人体动作和姿势,为动作捕捉和人机交互提供支持。在医疗领域,Sapiens可以通过精确的姿势和部位分析,辅助医疗专业人员进行病患监控和康复指导。对于社交媒体平台,Sapiens可以用于分析用户上传的图像,提供更丰富的互动体验。在虚拟现实和增强现实领域,它有助于创建更为逼真的人类形象,提升用户的沉浸式体验。

实验结果显示,Sapiens在多个任务上的表现超越了现有的最先进方法。无论是在全身、面部、手部和足部的关键点检测,还是在身体部位分割、深度估计和表面法线预测任务中,Sapiens都展现出了高精度和一致性。

首页

首页

AI对话

AI对话

资讯

资讯  我的

我的