在当今科技领域,CLIP(Contrastive Language-Image Pre-training)是一个重要的多模态基础模型。它通过在大规模图像 - 文本对上使用对比学习损失,将视觉信号和文本信号结合到一个共享的特征空间中。

CLIP 作为检索器,能够支持零 - shot 分类、检测、分割和图像 - 文本检索等多种任务。同时,作为特征提取器,它在几乎所有跨模态表示任务中占据主导地位,例如图像理解、视频理解以及文本到图像或视频生成。CLIP 的强大之处在于它能够将图像与自然语言相连接,并捕捉人类知识,这得益于其在大规模网络数据上的训练,其中包含详细的文本描述。

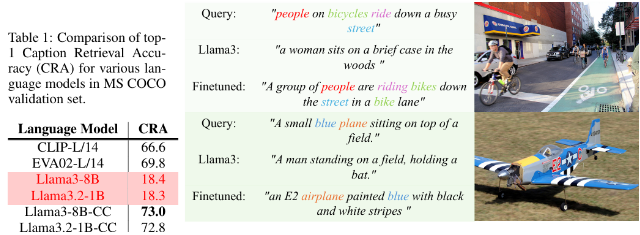

然而,CLIP 在处理长而复杂的文本说明方面存在一定的局限性。为了克服这一问题,微软和同济大学的研究人员提出了 LLM2CLIP 方法,旨在通过整合大型语言模型(LLMs)来增强视觉表示学习。这一方法大胆地替换了原有的 CLIP 文本编码器,利用 LLMs 的丰富知识来提升 CLIP 的视觉编码器性能。研究发现,直接将 LLMs 集成到 CLIP 中会导致性能下降,因此需要解决这一挑战。

LLM2CLIP 方法通过引入 “标题对比微调” 技术,大大提高了 LLM 在分离图像标题方面的能力,从而实现了性能的显著提升。

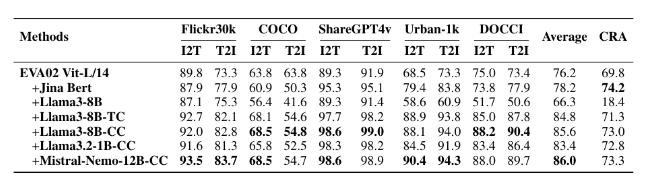

研究者们使用不同大小的数据集进行微调实验,包括小型的 CC-3M、中型的 CC-3M 和 CC-12M,以及大型的 CC-3M、CC-12M、YFCC-15M 和 Recaption-1B。结果表明,使用 LLM2CLIP 训练的模型在图像到文本及文本到图像检索任务中表现优于传统的 CLIP 和 EVA 模型。

通过与 Llava1.5等模型结合进行多模态训练,LLM2CLIP 在几乎所有基准测试中表现出色,尤其是在处理长短文本检索任务时,将之前的 EVA02模型性能提升了16.5%。这一创新方法不仅将 CLIP 从仅仅处理英文数据转变为一种强大的跨语言模型,也为 CLIP 训练的未来研究奠定了基础。

首页

首页

AI对话

AI对话

资讯

资讯  我的

我的