从美国西雅图往北走40公里,有一座安静的小城叫埃弗里特。几年前,有一家初创的小公司落户在了这里——这家公司叫Helion,主要业务是研究可控核聚变。

看着挺唬人的,但在这个时代其实不算稀罕。

搞出了《原神》的米哈游前段时间也投资了一家国内研究可控核聚变技术的企业。可见投资就像战国的诸侯大夫们养门客,100个门客里99个都是混饭吃的也不要紧,只要有一个“士为知己者死”,这钱就没白花。

Helion这家公司比较值得我们关注的,是它的股东们——2021年11月,Helion接受了一笔5亿美元的投资,而在此之前的8年时光里,这家公司一共也才接受了不到8000万美元的资金支持。

给Helion这么一大笔投资的“榜一大哥”叫Sam Altman,科技圈儿的朋友应该都知道这个人的另一个身份——OpenAI创始人、ChatGPT的亲爹。

除了投资核聚变企业外,Altman还自己创办了一家Oklo的核能领域初创企业。

连起来就是:世界顶级AI大佬,开始瞄准能源行业了。

01 击垮科技企业的,可能是水电费

AI创业未半而中道没电,今AI天下两分,美洲疲敝,此诚危急存亡之秋也……

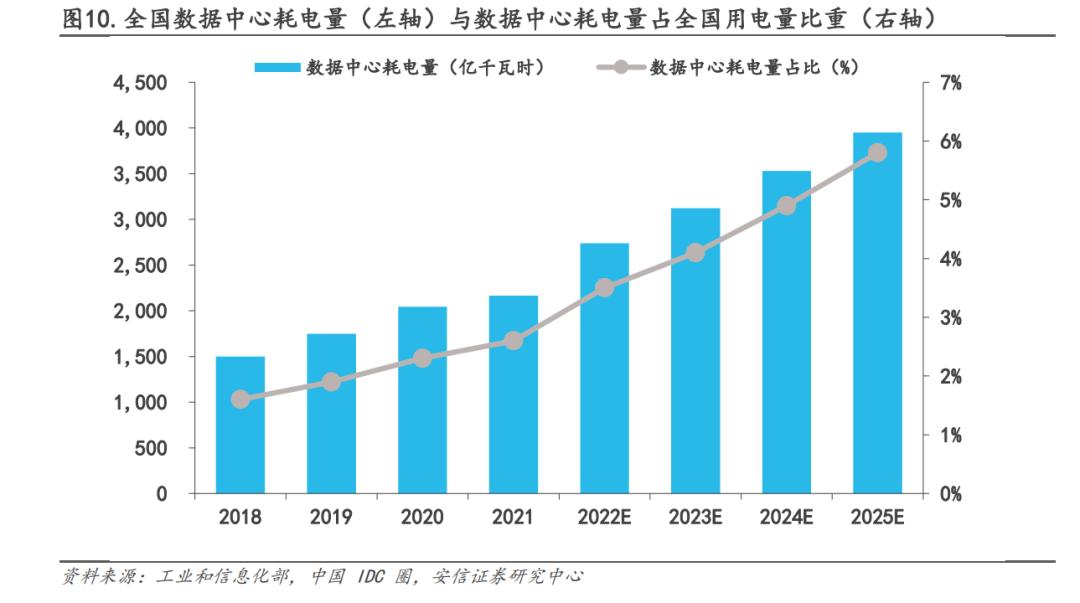

当中国的AI企业正在担心买不到先进GPU的时候,美国的AI企业正在担心电力问题——宾夕法尼亚大学的专家表示:五年前的2018年,计算机只用掉了全球不到2%的电力;但今天,这个比重已经涨到了10%,预计到2030年,计算机最多将会消耗全球五分之一的电力,至少也会消耗全球8%的电力。

其中,仅数据中心的耗电量就将占到全球用电量的2%。

2%,看着挺人畜无害是吧?

但我换个说法,你就知道这事情有多吓人了:

咱中国现在14亿人口,去掉老人和小孩,一共10亿活跃网民,咱们每天起床就开始玩手机,没事儿就刷抖音,中午点个外卖,下午在群里吹水聊天,而且各种消费基本全都是数字支付……这种程度的数字化生活,数据中心用电量也才占了全国用电量的2.7%。

“数据中心的耗电量将占到全球用电量的2%”——这相当于全球老百姓都过上了我们这种重度联网的生活——但现实是,咱们隔壁的印度都还有7亿人没联网呢。

这么一个远景,背后需要多少数据中心作支撑?这些数据中心又要多少电力去支撑?

另外,从绝对数字上来看的话,未来全球各处数据中心的用电量总和将轻松超越诸如一大堆欧洲小国家的用电量。

局长听过最丧心病狂的预测是:全球的计算需求可能会超越全球十年发电量的总和。

虽然如今“百模大战”很凶悍,但时间拉长,最后活下来的一定只有寥寥几家而已——想从这修罗场里走出来,你需要给自己的模型喂大量的数据,做海量的训练。仅以现在的水平来看,ChatGPT每个月的耗电量约等于将近30万户中国家庭的用电总和。

别忘了,很多数据中心也是要水冷的——谷歌发布的2023年环境报告显示,其2022年消耗了56亿加仑(约212亿升)的水,相当于37个高尔夫球场的水。其中,52亿加仑用于公司的数据中心,比2021年增加了20%。

今天,这个问题还不算严重,但能耗已经是芯片之外,计算行业里的第二大成本了。

虽然这个用电量总量在咱们中国人眼里看来也不是那么大,全球加起来也就是一个小县城的电量,但问题是需要为此买单的企业也并不多——请问诸位搞AI大模型的企业,到那时,您真的掏得起水电费吗?

当然,太阳底下没有新鲜事。

早在AI行业出现前,就已经有一个行业开始了自建电厂的道路——这就是电解铝行业。

电解铝生产

以之前局长参观过的东方希望准东园区来说,它的核心是准东电厂,露天煤矿挖出来的煤直接送到发电厂里燃烧发电,电能驱动了周边的电解铝厂和重化工工厂。

对像电解铝这样的行业来说,自建电厂的经济效益要比从电网里买电划算的多。

未来的AI行业,大概也是这意思。

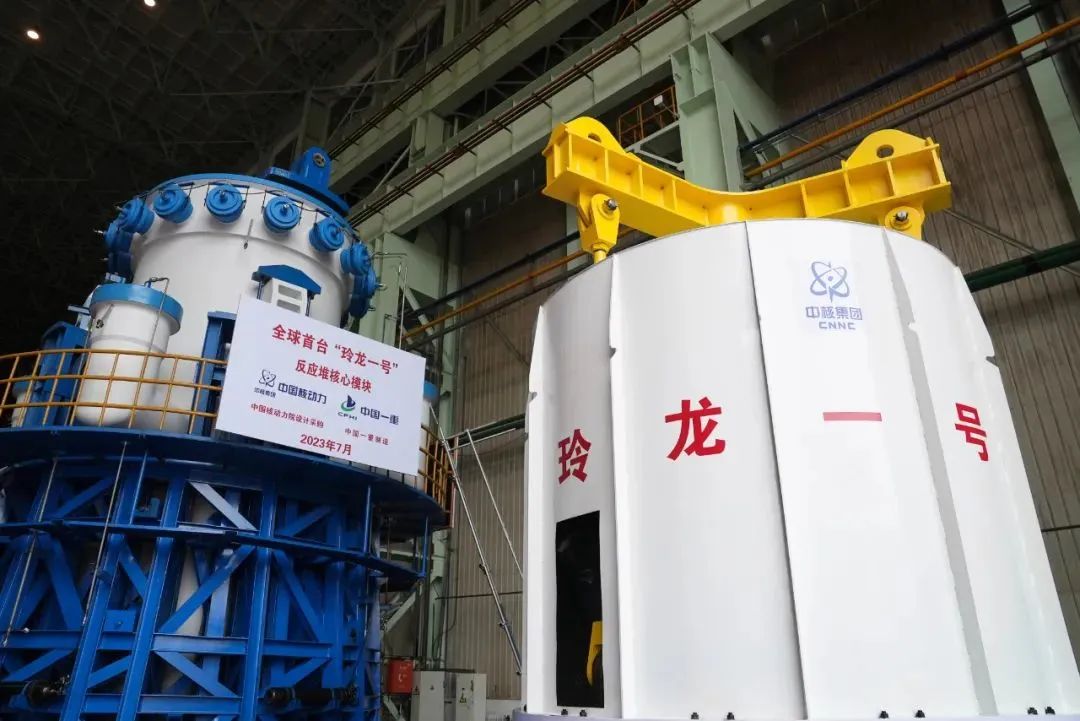

于是我们也就能理解美国人的想法了——考虑到欧美在碳排放方面的各种要求,微软和OpenAI的选择是核能——不是那种大型的核电站,而是小型的、可以快速部署的小型模块化反应堆(SMR)。

02 中国的AI企业是什么情况

但对中国的科技企业来说,数据中心的能源问题就是另一个故事了。我们当然也认识到了AI的能耗问题,不然《如何实现低能耗人工智能》不会被选入今年十大前沿科学问题。

中国AI企业没有像美国人那样布局能源行业的主要原因是没钱。

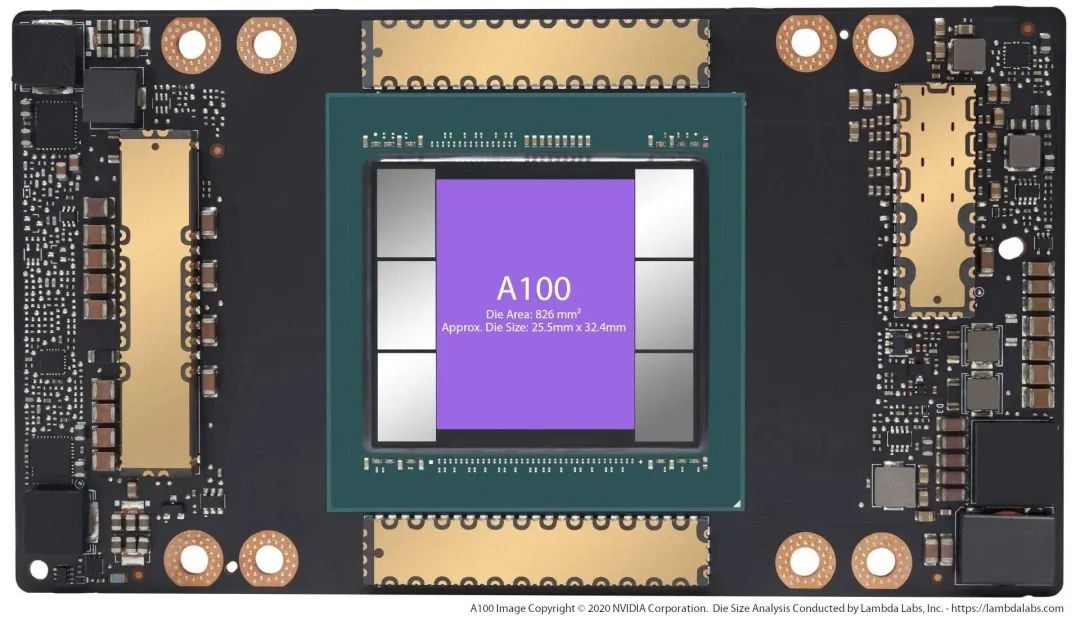

训练大模型是非常花钱的一件事情,首先就是要买大量的GPU——ChatGPT大概需要30000枚英伟达的A100 GPU芯片作为支持,采购成本8亿美元,每日电量5万美元。

百度十年的研发投入大概是1400亿元,大概200亿美元左右,平均到每年也就20亿美元——而ChatGPT光是每年的运营成本就已经要5亿美元了。

就是一分价钱一分货,没有什么窍门,真的就是钱堆出来的——光是研发和训练费用就已经让我们的AI企业头皮发麻了,还有什么余粮去研究能源问题么?

因此,对于中国的AI企业而言,基于现在的经济基础,思考能源问题多多少少还是有点太早了——百度文心一言作为国内最有名的大模型,日活用户也就几百万,还不到ChatGPT的一个零头——你让他去担心能源问题就真的是有点太超前了。

除了钱,技术也是一个重要的障碍。

低能耗的AI如何实现?一个靠硬件(芯片),一个靠软件(算法)——现在的算力基本都是靠先进制程在死撑,代价就是高能耗,在保证芯片性能的前提下降低能耗将会是一个重要的方向,要么就继续往前推进工艺节点,要么就是整出一个颠覆式的创新架构,实现接近于人类神经元的低能耗计算;再一个就是算法,让人工智能的算法更简洁一些。

这就不仅仅是AI企业的工作了,上游的芯片供应商和制造商也要动弹起来。

AI作为一个有潜力引发新一轮产业革命的关键技术,它的能量这么大,背后涉及的产业链就一定会特别漫长,会卷进去很多人,这都不是一个两个AI企业可以解决的。

03 中国要做好能源准备

对我们来说,做好能源准备总是没错的。

中国现在是全球第一发电大国,2022年的发电量接近9万亿度,大概是美国的两倍——超大规模的发电量背后,是中国超大规模工业体系带来的巨大用电量——冶金、化工等等行业都是超级用电大户,在这些行业面前,现阶段的AI用电量实在是有点不够看。

但我们应该注意的是,随着AI在各个行业的不断应用,AI的耗电量会越来越高,在突破某个临界点之后,AI的用电量可能会高到我们始料未及的一个程度——Altman为什么直接投资核能企业呢?既然总是要发电,为什么他不投资已经很成熟的风力、光伏等领域呢?

我的看法是:在Altman看来,未来AI的用电量极为巨大,只有核能才能满足。

图片来源:中核集团官网

中国和美国的AI竞赛,现在才开始。不得不说,在GPU这块,我们的技术确实还没有到那个层次,还是需要技术攻关和市场的认可,这个是半导体行业的问题,不是本篇的讨论范围。

但在能源技术上,我们还是颇有一些成就的。

就以小型模块化反应堆(SMR)来说,十几年前,我们就已经开始了SMR的研究——以中核集团的“玲龙一号”为例,作为一种基于成熟技术的创新型核反应堆,是全球首个通过IAEA安全审查的小型模块化压水反应堆,目前已经在建设过程中,2026年预计就可以投入实用了。

图片来源:中国电力报

在这一块,我们是有现成的产品可以用来满足未来需求的。

除了核能外,清洁能源上,我们的努力值得注意。

以光伏行业来说,中国也是世界一流的水平。坐标江苏常州的天合光能去年做了850亿的收入——中国光伏的扩张背后是我们在降低光伏发电的成本,这些年,中国每一度光伏电的发电成本降低了20倍。

低成本带来的优势是我们的竞争力增强了——中国光伏产品很大一部分都出口了——光伏组件占了全球75%的份额,电池片占了80%的份额,硅片上占了90%的份额。

而且,光伏现在已经不声不响地取代了水电,成为中国第二大电源了——三峡葛洲坝白鹤滩……我们玩儿了这么多年水电,谁能想到短短十年时间里,光伏就反超了呢?

……

综上所述,对于中国的AI企业来说,由于整体的市场还不算大,用户也不算多,能源问题并不像ChatGPT那样显得非常紧迫,故而短期内不需要太过于担忧能源问题,即便有所需求,市场上也有能够满足的现成解决方案。

首页

首页

AI对话

AI对话

资讯

资讯  我的

我的