近日,深度学习领域泰斗LeCun在WGS峰会上怒斥Sora模型不能真正理解物理世界,引起广泛关注。他指出,仅根据文字提示生成逼真的视频,并不代表模型理解了物理世界,与基于世界模型的因果预测有本质区别。

LeCun进一步解释,视频生成系统成功的标准是创造一个合理的样本,而真实视频的合理发展路径相对较少,尤其在特定动作条件下难度更大。他提出了联合嵌入预测架构(JEPA)的核心思想,强调生成后续内容的抽象表示,去除与行动无关的细节。

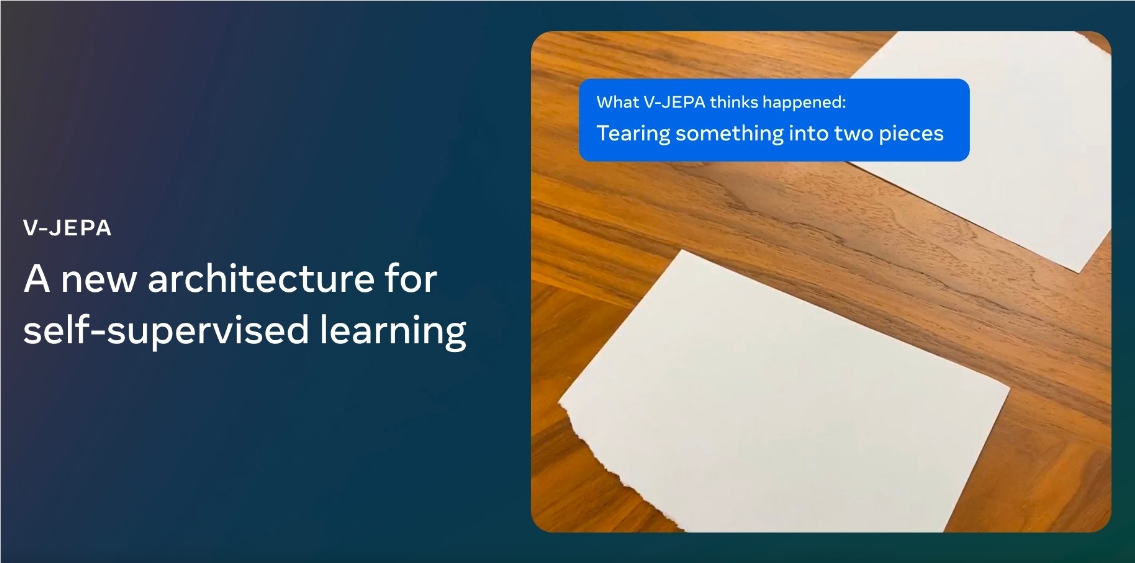

与此同时,LeCun展示了Meta公司发布的V-JEPA,一个非生成式模型,以人类的理解方式看世界。通过在抽象空间中预测视频中被遮挡或缺失的部分,V-JEPA在冻结评估上表现出色,可用于多个任务,标注使用效率优于其他模型。

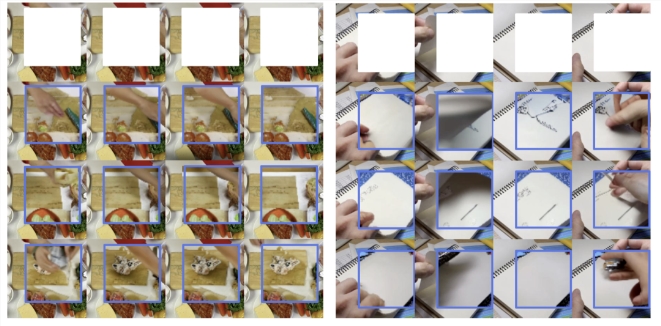

V-JEPA采用自监督学习方式,仅依靠未标记的数据进行预训练,然后通过标记数据微调模型。研究人员在视频中遮挡大部分内容,要求预测器补全缺失的内容,以一种抽象的描述形式在表示空间中填充内容。

值得一提的是,V-JEPA是首个在冻结评估上表现出色的视频模型,为模型学习新技能提供了高效快速的方法。研究还表明,V-JEPA在标注使用效率上优于其他模型,尤其在标注样本减少时表现更为出色。

虽然V-JEPA主要集中于视频的「视觉元素」,Meta公司表示下一步研究方向将包括同时处理视频中的「视觉和音频信息」的多模态方法。LeCun认为,V-JEPA是迈向对世界更深刻理解的关键一步,使机器能够进行更广泛的推理和规划。

V-JEPA的发布不仅是对Sora的回击,更展示了Meta公司在AI领域的先进技术,为实现具身AI技术和未来增强现实(AR)眼镜提供了有力支持。

V-JEPA模型的特色亮点功能包括:

视频理解能力: V-JEPA是一个非生成模型,通过在抽象表示空间中预测视频中缺失或遮挡的部分来学习。它在检测和理解物体之间高度详细的互动方面表现出色。

自监督学习方法: V-JEPA完全使用未标记的数据进行预训练,仅在预训练后才使用标签来适应特定任务。这种方法在减少所需标记样本数量和学习未标记数据方面显示出更高的效率。

遮蔽方法: V-JEPA采用一种特殊的遮蔽方法,通过在空间和时间上遮蔽视频的部分来迫使模型学习和发展对场景的理解。这有助于使模型更好地理解视频中的复杂互动。

抽象表示空间预测: V-JEPA通过在抽象表示空间中进行预测,使模型能够专注于视频包含的更高级别的概念信息,而无需关注像素级的细节。

低次冻结评估: V-JEPA是第一个在“冻结评估”中表现出色的视频模型,通过对编码器和预测器进行自监督预训练,然后仅在需要适应新技能时训练一个小型轻量级的专用层或网络。

多任务应用: V-JEPA的自监督方法使其能够适用于各种下游图像和视频任务,如图像分类、动作分类和时空动作检测,而无需调整模型参数。

未来研究方向: 该模型的未来方向包括采用更多模态的方法,如结合音频和视觉。此外,团队计划探索如何将V-JEPA的理解和规划能力应用于更长时间范围的视频任务。

项目介绍网址:https://ai.meta.com/blog/v-jepa-yann-lecun-ai-model-video-joint-embedding-predictive-architecture/

首页

首页

AI对话

AI对话

资讯

资讯  我的

我的