近日,阿里巴巴在其 Qwen-Audio 的基础上,推出了全新的开源语音模型 Qwen2-Audio。这款模型不仅在语音识别、翻译和音频分析方面表现出色,更是在功能和性能上实现了显著提升。Qwen2-Audio 提供了基础版和指令微调版,用户可以通过语音对音频模型提问,并识别和分析内容。

比如,用户可以让某位女性说一段话,Qwen2-Audio 可以判断她的年龄或分析她的情绪;如果输入一段嘈杂的声音,模型则能分析出其中的各种声音成分。Qwen2-Audio 支持包括中文、粤语、法语、英语和日语在内的多种语言,这为情感分析和翻译应用的开发提供了很大的便利。

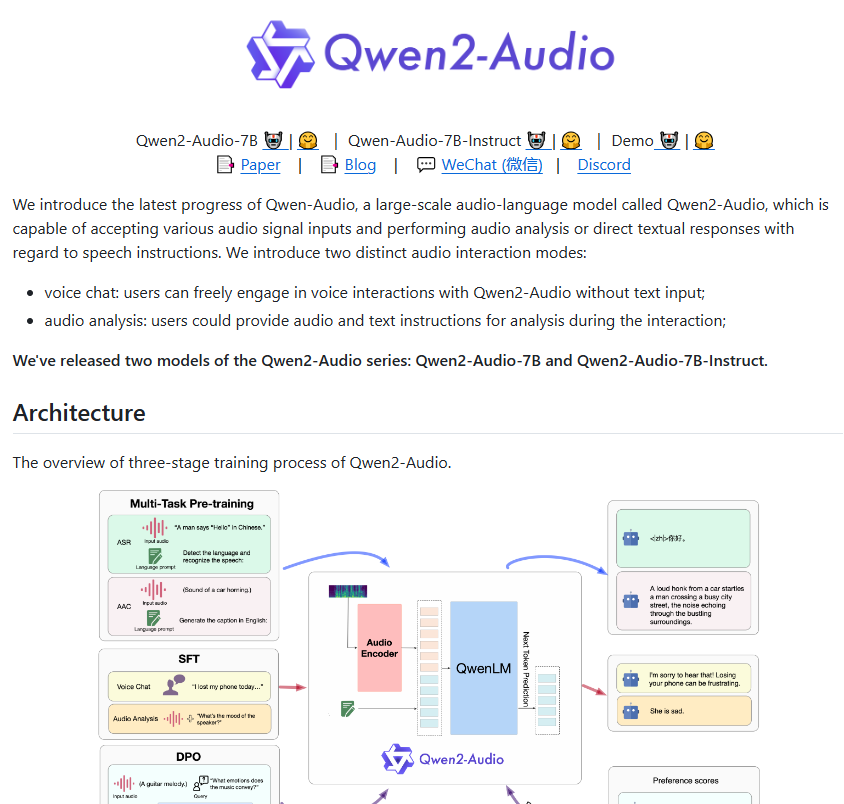

相较于第一代的 Qwen-Audio,Qwen2-Audio 在架构和性能上进行了全面优化。在预训练阶段,这款新模型采用了更为自然的语言提示,替代了之前的复杂分层标签。这一改进让模型在理解和响应各种任务时更加得心应手,泛化能力也得到了显著提升。

Qwen2-Audio 的指令跟随能力也大幅提高,能够更加准确地理解用户指令。例如,当用户发出 “分析这段音频中的情感倾向” 的指令时,Qwen2-Audio 可以精准判断音频中所蕴含的情感。此外,该模型引入了语音聊天和音频分析两种模式,让用户的语音交互更加自然。在音频分析模式下,Qwen2-Audio 能够深入分析各种类型的音频,并提供详尽准确的分析结果。

为了确保模型的输出符合人类的期望,Qwen2-Audio 还引入了监督式微调和直接偏好优化等先进技术。在与人类交互时,模型显得更加自然和精准。

在性能测试方面,Qwen2-Audio 在多个主流基准测试中表现优异,尤其是在语音识别和翻译的准确性上,超越了 OpenAI 的 Whisper-large-v3。这款新模型的表现不仅在业内引发了广泛关注,也预示着语音技术的新未来。

首页

首页

AI对话

AI对话

资讯

资讯  我的

我的