最近,DeepMind一篇关于超大规模 Transformer 在国际象棋领域应用的论文,引发了 AI 社区的广泛讨论。研究人员利用名为 ChessBench 的全新数据集,训练了多达2.7亿参数的 Transformer 模型,探索其在棋类这种复杂规划问题上的能力。

ChessBench 数据集包含从 Lichess 平台收集的1000万局人类对弈棋谱,并使用顶级象棋引擎 Stockfish16对棋局进行了标注,提供了多达150亿个数据点,包括每个棋局状态的胜率、最佳走法以及所有合法走法的价值评估。

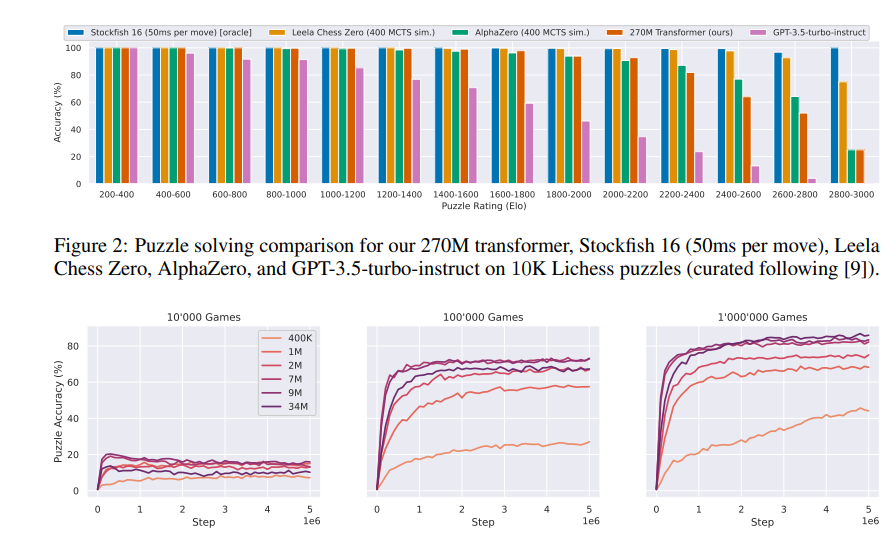

研究人员使用监督学习方法,训练 Transformer 模型预测给定棋局状态下每个合法走法的价值。实验结果表明,即使没有使用任何显式搜索算法,最大规模的模型也能在全新的棋局状态下做出相当准确的预测,展现出强大的泛化能力。

令人惊讶的是,该模型在 Lichess 平台上与人类玩家进行快棋对弈时,取得了高达2895的 Elo 等级分,达到了国际象棋大师级别。

研究人员还将该模型与 Leela Chess Zero 和 AlphaZero 等基于强化学习和自我博弈训练的棋类引擎进行了比较。结果表明,尽管通过监督学习可以将 Stockfish 搜索算法的近似版本提炼到 Transformer 模型中,但要实现完美的提炼仍然存在挑战。

这项研究表明,超大规模 Transformer 模型在解决复杂规划问题方面具有巨大潜力,也为未来 AI 算法的开发提供了新的思路。ChessBench 数据集的发布,也将为研究人员探索 AI 规划能力提供一个新的基准平台。

首页

首页

AI对话

AI对话

资讯

资讯  我的

我的