当前,多模态大型语言模型(MLLM)在视频理解领域取得了显著进展,但处理超长视频仍然是一个挑战。 这是因为,MLLM 通常难以处理超过最大上下文长度的数千个视觉标记,并且会受到标记聚合导致的信息衰减的影响。 同时,大量的视频标记也会带来高昂的计算成本。

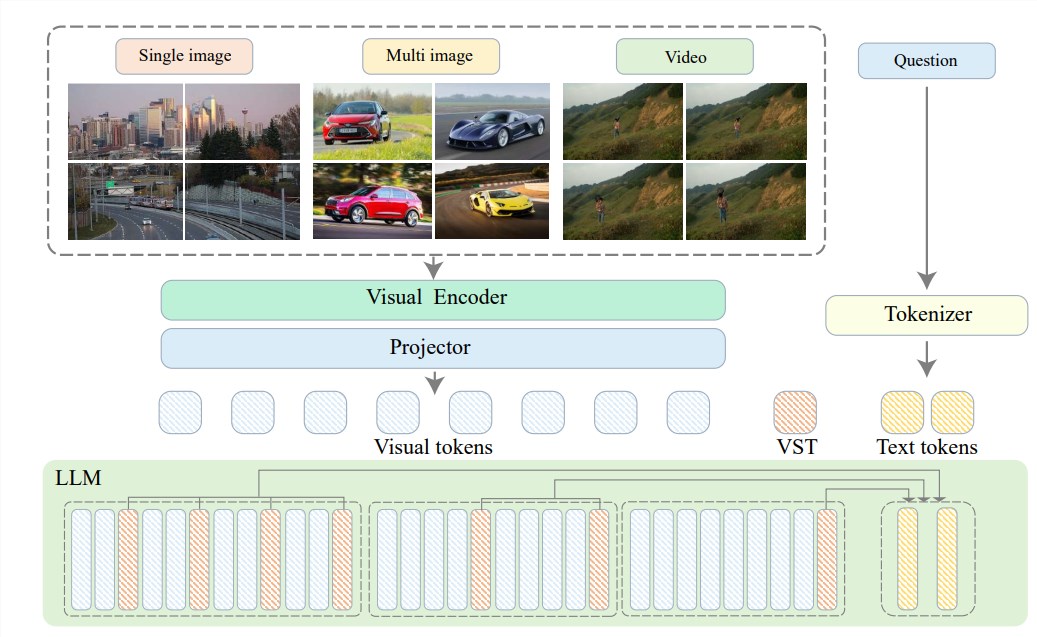

为了解决这些问题,智源研究院联合上海交通大学、中国人民大学、北京大学和北京邮电大学等多所高校提出了 Video-XL,这是一种专为高效的小时级视频理解而设计的超长视觉语言模型。 Video-XL 的核心在于“视觉上下文潜在摘要”技术,它利用 LLM 固有的上下文建模能力,将长视觉表示有效地压缩成更紧凑的形式。

简单来说,就是把视频内容压缩成更精简的形式,就像把一整头牛浓缩成一碗牛肉精华,方便模型消化吸收。

这种压缩技术不仅提高了效率,还能有效保留视频的关键信息。要知道,长视频里经常充斥着大量冗余信息,就像老太太的裹脚布,又长又臭。Video-XL 则能精准地剔除这些无用信息,只保留精华部分,这就保证了模型在理解长视频内容时不会迷失方向。

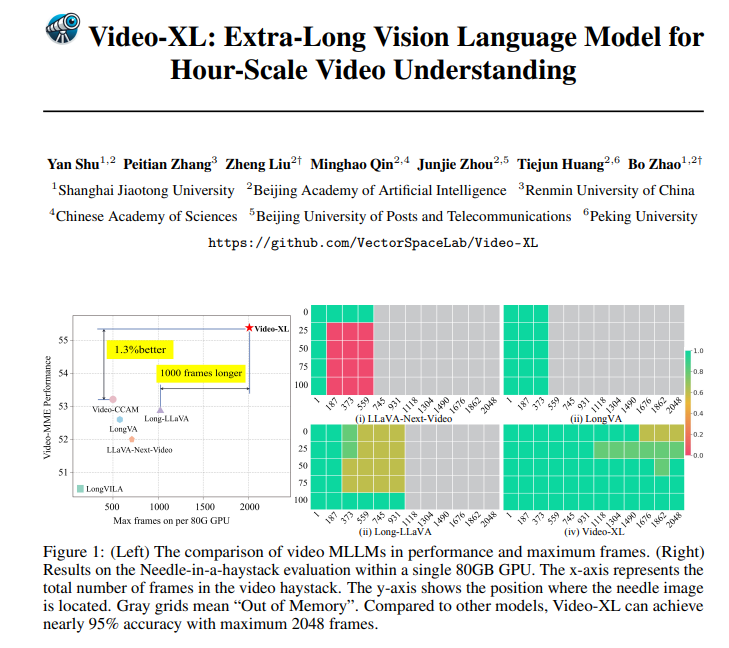

Video-XL 不仅理论上很牛,实战能力也相当强悍。在多个长视频理解基准测试中,Video-XL 都取得了领先的成绩,尤其是在 VNBench 测试中,它的准确率比现有最佳方法高出近10%。

更令人印象深刻的是,Video-XL 在效率和效果之间取得了惊人的平衡,它可以在单个80GB GPU 上处理2048帧视频,同时在“大海捞针”评估中仍能保持近95% 的准确率。

Video-XL 的应用前景也非常广阔。除了能理解一般的长视频,它还能胜任一些特定任务,比如电影摘要、监控异常检测和广告植入识别。

这意味着以后看电影不用再忍受冗长的剧情,直接用 Video-XL 生成一份精简的摘要,省时又省力;或者用它来监控监控画面,自动识别异常事件,比人工盯梢效率高多了。

首页

首页

AI对话

AI对话

资讯

资讯  我的

我的