AI大模型自诞生之日起,其幻觉就难以避免。因为从底层规则来看,大模型被强制要求一定要有回应,但它确实会出现无法回答的情况,自然就会胡说八道。一边是厂商不断加高的安全壁垒,另一边是用户不断尝试,设法在已有的规则中找寻突破口。就如几十年前互联网刚普及时一样,这注定将成为一场“猫鼠游戏”。“AI大模型目前的这一结构令其在技术上无法消灭幻觉,只能在工程上尽可能避免。”Listenhub运营负责人马克斯说

◎记者 罗茂林

大模型的普及让全球内容生产正经历一场重构。近期,部分大模型突破框架,输出不雅回复的新闻一度在社交媒体上发酵。与此同时,各类诸如“关公战秦琼”的AI幻觉,也令模型商业化落地难以真正令人满意。

“生成式”内容带来的冲击远不止于此。日前,法国、马来西亚及印度的监管部门共同向马斯克旗下的AI聊天机器人(18.600, 0.25, 1.36%)Grok发难:该模型生成大量针对女性和未成年人的性相关伪造内容。相关部门谴责称,这样的行为正在突破法律和伦理的底线。

新生事物的发展总伴随争议与挑战,当“生成式”内容正以前所未有的规模进入大众生活,新的规则边界也需要在探索中逐渐形成。

AI大模型:与幻觉共存

近期,有用户称在使用大模型时模型出现不雅回复,一时间引发网友关注。

“这件事在业内来看有点蹊跷,因为输出的内容连格式都和一般的模型对话不太一样。”Listenhub运营负责人马克斯告诉上海证券报记者,这种不寻常的情况有可能意味着大模型被注入过特殊指令。

一位AI大模型工程师告诉记者,目前AI大模型训练中工程师往往会为大模型设定一套底层“人设”:“它可以理解为大模型的一个人格,包含了很多禁止性约束,在内容输出前起到审核作用,确保输出内容合规。”

而所谓注入指令,便是用户通过输入特定的词语,让大模型短时间内忘掉被工程师设定的“人格”。在此背景下,模型可能突破既定规则,这也被业内视为AI大模型幻觉的一种表现。

汇正财经资深投资顾问冯涛告诉记者,从目前大模型行业的训练惯例来看,AI产生幻觉大致包括两方面原因:一方面是初始的训练数据可能存在少量错误、噪声或覆盖盲区;另一方面是模型对复杂逻辑的推理能力不足,知识关联建模存在缺陷而导致的漏洞。

“国内外的大模型产品,本质上叫next token prediction,这就是说模型在生成答案时,是基于概率预测下一个词,而不是真正地进行逻辑推理或计算。所以为了流畅或其他原因,有可能会产生一些很奇怪的说法。”深圳大学一位专攻大语言模型及其安全领域的副教授告诉记者,“出现这些幻觉更本质的核心原因,还是当前的计算能力受限了。”

在马克斯看来,AI大模型自诞生之日起,幻觉就难以避免。“因为从底层规则来看,大模型被强制要求一定要有回应,但它确实会出现无法回答的情况,因此自然就会胡说八道。”

一边是厂商不断加高的安全壁垒,另一边是用户不断尝试,设法在已有的规则中找寻突破口。就如几十年前互联网刚普及时一样,这注定将成为一场“猫鼠游戏”。

“AI大模型目前的这一结构令其在技术上无法消灭幻觉,只能在工程上尽可能避免。”马克斯说。

“生成式”内容:规则边界的重新定义

如何尽可能减少AI幻觉?除了确保源头数据的准确以外,建立更加多维且可靠的安全墙是最好的选择。

马克斯告诉记者,除了在输出前增加新的对抗性“人格”,再次确保内容合规外,使用检索增强生成技术也成为现在厂商的选择之一,“这个技术相当于一个外置的知识库,大模型在输出前再到库里检索一遍,以确保内容准确”。

记者注意到,目前不少厂商在医疗、金融、教育等对准确度要求极高的场景中都使用了相关技术。

尽管如今AI大模型幻觉触发的概率正变得越来越低,但在越发庞大的总量面前,这些“胡言乱语”的数量仍不能小觑。更重要的是,不少内容甚至伴随对既有社会法规的挑战。

近期,印度电子信息技术部发布命令,要求X平台必须采取措施,限制Grok生成“淫秽、色情、低俗、猥亵等违法内容”。同期,法国、马来西亚的监管部门也宣布了对Grok违规行为的审查。

对此,马斯克发文称:“任何利用Grok生成非法内容的人,都将面临与上传非法内容同等的后果。”

早前,有用户通过Grok生成了儿童色情图片引发社交媒体震动。Grok官方随后紧急发文致歉,表示这是安全防护机制的一次失效,“我们对由此造成的任何伤害深表歉意。正对此事展开审查,以杜绝类似问题再次发生”。

采访中,多位业内人士表示,尽管国内目前对于生成式内容的管理整体更为有序,但潜在的争议仍需要明确。“比如说对于生成内容,究竟是由大模型厂商、使用模型的商家,还是由用户承担责任,这些都需要明确。”马克斯说。

记者注意到,在国内,围绕生成式内容的管理目前已有一定的法规指引。2023年1月10日起施行的《互联网信息服务深度合成管理规定》明确规定,对“可能导致公众混淆或者误认的”深度合成服务情形需做出显著标识。

在此基础上,2025年9月1日,国家网信办等四部门联合发布《人工智能生成合成内容标识办法》进一步细化规则,提出“显式标识”与“隐式标识”的双轨标识制度。

“根据《生成式人工智能服务管理暂行办法》第十四条第一款的规定,提供者发现违法内容的,应当及时采取停止生成、停止传输、消除等处置措施,采取模型优化训练等措施进行整改,并向有关主管部门报告。”北京市京师律师事务所律师孟博告诉上海证券报记者,新修改的《中华人民共和国网络安全法》也进一步要求完善人工智能伦理规范。

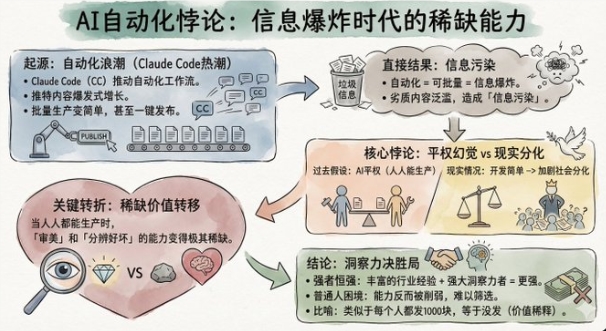

没有人能准确估计如今AI生成内容的总量。据搜索引擎优化公司Graphite估算,截至2025年5月,仅在英文互联网,AI生成的内容数量已占据整个互联网书面内容的52%。

这注定是一个AI蓬勃生长的时代。有意思的是,全球知名的韦氏词典(Merriam-Webster)宣布,将“slop”选定为2025年度词汇,这个本意为“残羹剩菜”的词语,如今被引申为由人工智能批量生成的低质量数字内容。

“这是一个全新的领域,不仅是技术,很多的规则制度都需要各方去完善,从而确保人工智能能够真正实现科技向善。”孟博说。

首页

首页

AI对话

AI对话

资讯

资讯  我的

我的