阿里巴巴达摩院联合魔搭社区ModelScope近期宣布开源一项新的多语言基准测试集P-MMEval,旨在全面评估大型语言模型(LLM)的多语言能力,并进行跨语言迁移能力的比较分析。这一测试集覆盖了基础和专项能力的高效数据集,确保了所有挑选的数据集中多语言覆盖的一致性,并提供了跨多种语言的并行样本,最高支持来自8个不同语族的10种语言,包括英语、中文、阿拉伯语、西班牙语、日语、韩语、泰语、法语、葡萄牙语和越南语。

P-MMEval的推出响应了开发和迭代大型语言模型时对准确且并行评估结果的需求,这对于识别模型的多语言能力和量化性能至关重要。早期工作主要集中在单一任务评估上,而近期研究提出了一些大规模多语言多任务评估基准,统一了多个具有代表性的独立基准任务。然而,这些大规模基准测试集在覆盖多语言种类上并不一致。

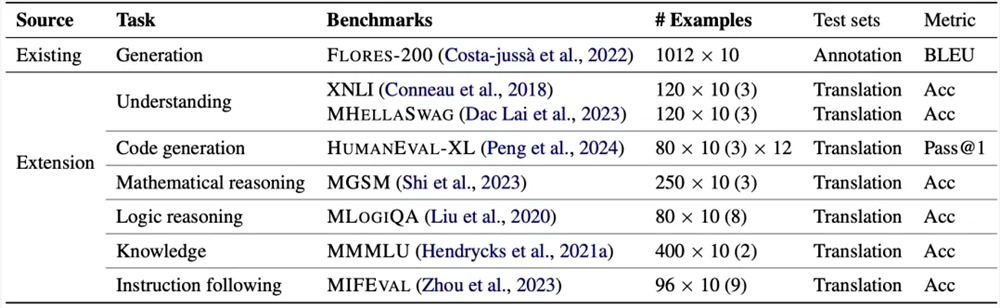

P-MMEval基于一种基于显著性检验的方法挑选可用且合理的基准测试集,整合了基础自然语言处理任务和能力特定的评估任务,确保每个任务在语言覆盖上的一致性,并提供跨语言的平行样本,以便进行一致的比较。对于任务多样性,P-MMEval涵盖了两个关键的基础NLP任务(生成和理解)以及当前LLM的五种核心能力。在语言多样性方面,P-MMEval统一了涵盖八个语系的十种不同语言。

P-MMEval数据集已经集成到司南评测体系OpenCompass和EvalScope评测框架中,使用这两个框架均可以执行评测任务。OpenCompass提供了一个开源、高效、全面的大模型评测开放平台,支持大语言模型、多模态模型各类模型的一站式评测,并定期公布评测结果榜单。P-MMEval也在第一时间接入了OpenCompass的评测体系,可使用司南OpenCompass开源工具完成评测任务。

研究人员评估了几种代表性的指令调优模型的性能,包括闭源模型GPT-4o、Claude-3.5和开源模型LLaMA3.1、LLaMA3.2、Qwen2.5等。实验结果表明,除了LLaMA3.2系列外,所有模型的多语言能力随着模型规模的增加而提高。Qwen2.5在理解和专项能力任务上表现出强大的多语言性能,而Gemma2在生成任务上表现出色。闭源模型总体上优于开源模型。

P-MMEval的推出为大模型的多语言能力评估提供了新的工具和方法,有助于推动多语言NLP技术的发展和应用。

首页

首页

AI对话

AI对话

资讯

资讯  我的

我的